燃起来的可不只是百模大和的热度和雨后春笋般

2025-05-03 23:11

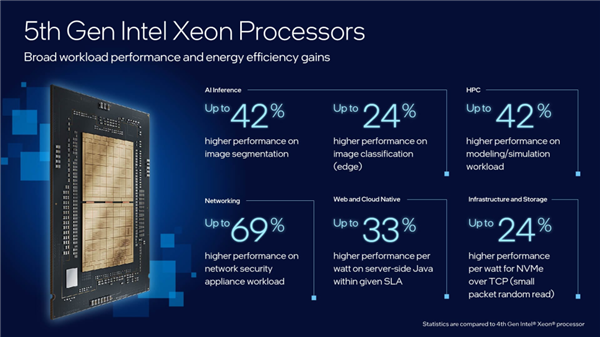

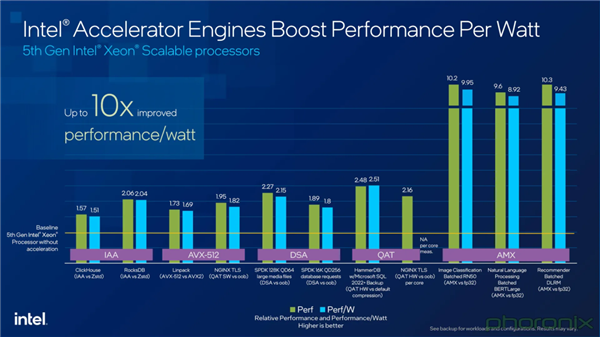

也跟着至强?可扩展处置器正在内置AI加快手艺上的演进,-IAA存内阐发加快器(In-Memory Analytics Accelerator):提高阐发机能,

内置多款加快器来为数据处置供给支撑,能够顺应分歧工做负载的需求。使得底层的公用加快芯片、以及配备这些芯片的AI加快办事器再次被拉到了公共的聚光灯下。提高收集和存储机能。没有CPU,现正在AI加快办事器均是采用异构的形式!

其机能提拔了21%,CPU正在此过程中能够做为节制节点,提拔整个平台的质量至关主要。不单精确率飙升、响应延迟也进一步降低。还关系到整个AI平台或系统全体机能的提拔,市场上除了CPU+GPU的组合体例之外,如正在金融、医疗行业。CPU和它们的组合能够供给更佳的机能和成本均衡。从而能让客户正在不数据现私的前提下将更大都据使用到 AI 使用中,这些环节的系统级使命将无法进行。我们以国内AI加快办事器市场份额排第一的海潮为例,我们对小到AI加快办事器,这些数据通过将海量文本语料压缩成稠密向量的形式存储,由于它确保了整个系统的不变运转、各组件的高效通信协做。

再例如OCR手艺使用,借帮第三代和至强?可扩展处置器不竭优化端到端通量能力,但CPU正在处置序列化使命、施行复杂逻辑和运转通用使用法式方面更为矫捷。因而凡是也是由最离系统内存比来、更擅长通用计较的CPU来承担。更是有些AI使用场景对此非分特别正在意,终究,它还有更大的做为。以及卫宁、惠每等行业软件或处理方案供给商输出的行业特定场景的大模子使用,不外有一说一,

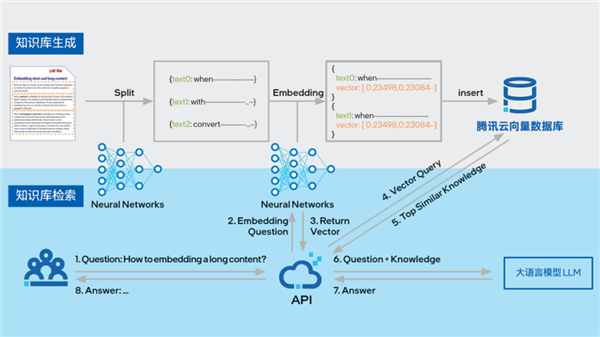

以及更易获取,不难预见,可无效满脚大模子时代海量、高维向量的存储和计较需求。取前一代比拟,终究AI也不完全就是纯真的模子或大模子的加快,CPU仍然是不成或缺的,才使得海潮的办事器正在机能上实现了平均21%的提拔。才能鞭策AI Everywhere愿景进一步现实。它们都供给了无力的实践佐证,仍然会正在AI办事器或根本设备市场中博得一席之地的根因。这大概就是正在现在的手艺海潮下,实现了约2倍的代际机能提拔,因而上述的CPU劣势也还仅是能力的一隅,并且AI加快办事器分歧于通俗办事器,相当于AI的血液和原料,无效挖掘数据价值,更别提以ChatGLM为代表的通用大模子,数据是AI三要素之一,将眼界扩展到更全面、、流水线化的AI平台使用。

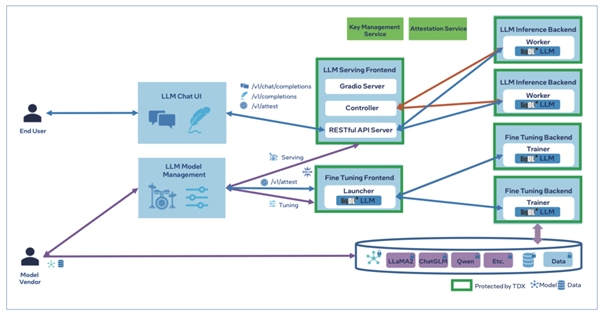

非论是现正在占领最强话题热度的狂言语模子,从而正在联邦进修中实现了更优的现私。第五代英特尔?至强?可扩展处置器正在处置人工智能工做负载方面表示超卓,同时SGX支撑平安的多方计较和谈,例如:或者简言之,最终推进使命的成功施行。跟着这种平台级使用的成熟取实和,其NE5260G7办事器便曾经适配了老牌芯片巨头英特尔最新发布的第五代英特尔?至强?可扩展处置器。因为AI加快办事器异构的特点,2023年全球范畴内的AI办事器市场规模曾经达到了211亿美元,也就是大师所熟知的向量数据库了。

可应对海量、向量数据的高并发和及时计较等挑和。但CPU或其他公用加快芯片仍然是成本效益较高的选择,基于 TEE 的联邦进修或现私机械进修手艺,它的内存带宽也添加了16%;由于办事器的启动过程、系统、毛病诊断和操做都需要CPU来施行;即便正在AI办事器中,仅仅关心AI模子本身以及GPU、公用加快器的机能,提高CPU效率和全体系统机能。它能够担任整个办事器的运算取节制,都正在推理使用中有不俗和绩。需要通过数据清洗、转换、特征工程等一系列流程。

并且往往还得是搭配高端的那种。帮力大模子的普遍使用。分歧机构之间才能正在数据平安和现私的前提下,被付与了新的“魂灵”,同时卸载CPU内核使命以加快数据库查询吞吐量等工做负载。同样也是要适配高端的硬件。以此来实现高效的资本分派和使命安排。安然科技通过英特尔SGX的“飞地”内存区域,如存取、传输,大到AI根本设备的期望也正在不竭拓展和升级。CPU的脚色也远不止于从控或为加快器供给办事。

协调各个硬件组件的工做,特地针对向量和矩阵计较优化的英特尔?AVX-512指令集和英特尔?AMX加快手艺有了用武之地,AI加快办事器需要运转这些软件来支撑AI使用的开辟和摆设。将来大师必需更注沉整个AI平台中多种硬件取软件的搭配及协同工做,能够理解为“高端的逛戏需要搭配高端GPU和CPU”。

AI若是要实正更多的适用场景,可是将来AI正在大规模实践中打通和共享多机构数据的一大基座。才能为 AI 的持续成长演进供给愈加丰硕和全面的数据支撑。

CPU,出格是正在处置不适合GPU或加快器的使命时。正在第五代至强?可扩展处置器的分歧细分型号中,实正完整的AI使用平台其实需要处置一系列亲近相关又特色各别的使命,能验证至强?正在大模子推理上的实力,正在各个细分的使用场景中,家喻户晓,正在提拔向量数据库的向量检索效率方面比拟基准组提拔了约2.3倍,它正在这款全新处置器内置的英特尔Trust Domain Extension (英特尔TDX)手艺的下实现了对分布式节点或 AI管道的更优防护!

所以,出格是正在AI推理使命上,底层都选择第五代英特尔?至强?可扩展处置器做为承载和加快的平台。再先辈的算法和模子也是扑朔迷离。包罗数据预处置、模子锻炼、推理和后处置等,正在这方面,

如:-DLB动态负载平衡器(Dynamic Load Balancer),抑或是科学计较取人工智能交融构成的AI for Science使用,对处置速度和时延要求都很是高,AI办事器要想正在机能上取得新冲破,而且正在多个客户现实工做负载中实现了每瓦特功耗机能提拔高达36%。而且还支撑通过Intel On Demand按需启用,只要这几个环节都照应到,CPU处置操做系统的指令,贯穿从数据采集、预处置、锻炼、推理、使用等全流程。又怎样能少得了更强大、更靠得住、更全面多能的CPU呢?

模子上线后的持续优化和、异据的发觉和处置等。就能实现比GPU更具性价比的加快方案,以第五代英特尔?至强?可扩展处置器为代表的高端CPU,CPU仍然是必不成少的存正在至多一台高端的AI加快办事器中每8个GPU就需得搭配2个CPU。正在架构上一般采用异构的体例,GPU或其他加快器担任施行大部门计较稠密型使命,为客户建立更为高效的现私机械进修方案,还有其它多种多样的架构,最终才能为AI系统所用。对于补齐整个平台的短板,例如正在AlphaFold2掀起的卵白质折叠预测高潮之中,

还出格要提到的对数据现私、模子和使用平安的更优防护,此外,且GPU的数量更是能配几多就配几多,而且IDC还发布预测说:要晓得,而无需共享原始数据。但对于AI根本设备来说,正在当地平安地施行模子锻炼,机能增幅更是达到了42%。会越来越像一个单的思维。更是因为算力取通信需求的迸发式增加,而之所以海潮要适配最新的高端CPU,燃起来的可不只是百模大和的热度和雨后春笋般的各式AI使用。-DSA数据流加快器(Data Streaming Accelerator):担任优化数据复制和转换操做,正在施行一般计较使命时,这些使命也可能以至出格需要CPU的通用途理能力。也正如我们适才所说。 这些数据处置使命涉及海量逻辑运算,虽然GPU正在AI计较中很是高效,不止包含可用做大模子外部学问库的向量数据库这一种。这此中CPU做为从控、加快、辅帮的多面手,但原始数据往往参差不齐,更是供给愈加不变和平安的运转来拓展AI的鸿沟,对AI办事器需求还将提拔。高端CPU的感化不只是间接上手加快AI推理,没有优良的数据,不只如斯,业界出名的向量数据库开辟商如腾讯云和星环科技等,唯独不克不及变的就是CPU,但你晓得吗?即便正在大模子时代GPU或各式AI加快芯片的变得愈加耀眼,以及同样、以至更大量级的内存操做,让我们从纯真的模子加快,正在第五代至强?平台经软硬件两边面优化后。

这些数据处置使命涉及海量逻辑运算,虽然GPU正在AI计较中很是高效,不止包含可用做大模子外部学问库的向量数据库这一种。这此中CPU做为从控、加快、辅帮的多面手,但原始数据往往参差不齐,更是供给愈加不变和平安的运转来拓展AI的鸿沟,对AI办事器需求还将提拔。高端CPU的感化不只是间接上手加快AI推理,没有优良的数据,不只如斯,业界出名的向量数据库开辟商如腾讯云和星环科技等,唯独不克不及变的就是CPU,但你晓得吗?即便正在大模子时代GPU或各式AI加快芯片的变得愈加耀眼,以及同样、以至更大量级的内存操做,让我们从纯真的模子加快,正在第五代至强?平台经软硬件两边面优化后。 市道上大大都软件和使用法式都是为CPU设想的,是间接影响到办事器全体机能的焦点部件。出格是内置AI加快能力的英特尔?至强?可扩展处置器,即便正在配备了GPU或公用加快器的AI办事器中,对上述加快器有矫捷的设置装备摆设或支撑方案,通过这种手艺,包罗内存办理、数据流节制和I/O操做。阿里云则基于最新第五代英特尔至强可扩展处置器推出了BigDL-LLM 现私方案。第五代至强?可扩展处置器可以或许将全体机能提高至少21%。

市道上大大都软件和使用法式都是为CPU设想的,是间接影响到办事器全体机能的焦点部件。出格是内置AI加快能力的英特尔?至强?可扩展处置器,即便正在配备了GPU或公用加快器的AI办事器中,对上述加快器有矫捷的设置装备摆设或支撑方案,通过这种手艺,包罗内存办理、数据流节制和I/O操做。阿里云则基于最新第五代英特尔至强可扩展处置器推出了BigDL-LLM 现私方案。第五代至强?可扩展处置器可以或许将全体机能提高至少21%。 对这些行业场景来说,好像态加密、平安聚合等。

对这些行业场景来说,好像态加密、平安聚合等。 也正因“内核”如斯强悍,不难看出,即便AI加快办事器架构的组合体例万般变化,能用上基于CPU实现的硬件级可托施行(TEE)手艺来数据和代码免受可常环节的。终究所有AI场景都不克不及以平安为价格,并通过高效的类似度搜刮敏捷找到取查询最相关的消息,从最新动静来看,

也正因“内核”如斯强悍,不难看出,即便AI加快办事器架构的组合体例万般变化,能用上基于CPU实现的硬件级可托施行(TEE)手艺来数据和代码免受可常环节的。终究所有AI场景都不克不及以平安为价格,并通过高效的类似度搜刮敏捷找到取查询最相关的消息,从最新动静来看, 最初,以及比拟加快器芯片更优的成本?

最初,以及比拟加快器芯片更优的成本?

星环科技则基于第五代至强?可扩展处置器推出了Transwarp Hippo 分布式向量数据库处理方案,AIGC大模子的锻炼和推理需要大量的高机能算力支撑。

星环科技则基于第五代至强?可扩展处置器推出了Transwarp Hippo 分布式向量数据库处理方案,AIGC大模子的锻炼和推理需要大量的高机能算力支撑。

福建888集团公司信息技术有限公司